Der neue BARC BI Survey 2019

16. November 2019

KI – Stressthema oder echte Chance für den Mittelstand

14. Januar 2020

KI? AI? DL? ML? – Hier kommt Klartext!

Einleitung

Künstliche Intelligenz. Ein Schlagwort der Moderne. Faszinierend und beängstigend zugleich. Da werden Schreckensszenarien aus Science-Fiction Blockbustern gemalt, in denen Maschinen die Herrschaft übernehmen. Eiskalt. Emotionslos. Aber Stopp und mal ernsthaft: Was hat es mit dieser Künstlichen Intelligenz denn so auf sich. Ich mag den Begriff zum Beispiel gar nicht. Ich rede von AI – Artificial Intelligence (AI), denn dem „eingedeutschen“ Begriff wird die Technik und die damit verbundene Erwartungshaltung nicht – oder noch nicht – gerecht. … und Intelligence hat im Englischen nun mal nicht nur die Bedeutung von Intelligenz, sondern auch von Information. Aber was ist AI denn überhaupt? Was versteht man darunter und wo sind Einsatzgebiete? Wo begegnet sie uns bereits im Alltag oder sind das alles nur Zukunftsvisionen? Wir schauen es uns einmal genauer an.

Technische Evolution

Werfen wir einen Blick auf die Entwicklung der Technik der letzten zwanzig Jahre und würdigen kurz Gordon Moore und seinem mooreschen Gesetz, das besagt, dass sich die Komplexität integrierter Schaltkreise mit minimalen Komponentenkosten regelmäßig verdoppelt; je nach Quelle werden 12, 18 oder 24 Monate als Zeitraum genannt. Er formulierte dieses Gesetz im Jahre 1965 und verstand unter Komplexität die Anzahl der Komponenten auf einem integrierten Schaltkreis. Diese technische Entwicklung bildet eine wesentliche Grundlage der „digitalen Revolution“. Und Moore hatte Recht:

Das was in den letzten Jahrzehnten an Entwicklung stattfand, hat Folgen: Die Leistung von Rechnern und Kommunikationsnetzen hat sich vertausendfacht. Ebenso sieht es bei der Entwicklung von Speichergrößen aus. Dabei wurden die Komponenten und Geräte immer kleiner und leichter. Ach ja, in der heutigen Welt ein wichtiger Fakt: Sie wurden auch günstiger.

Technische Revolution

War es vor 20 Jahren noch undenkbar Methoden der Informatik anzuwenden, so sind die technischen Hürden nun überwunden. Schrift- und Bilderkennung, Planung, Optimierung, maschinelles Lernen und Robotik sind möglich. Noch viel besser: Sie sind bereits in unserem Alltag vorhanden.

„Siri, Siri an der Hand: Wo geht es hin mit KI in unserem Land?“ Gefragt wurde meine Apple Watch. Geantwortet hat Siri nur mit Vorschlägen zu Sonnenstudios in meiner Nähe. Wir stehen eben erst am Anfang. Aber wir stehen an einer Schwelle zu einer ganzen Reihe neuer Anwendungen. Jenseits dessen, was klassische Computerprogramme uns bisher bieten. Computer werden zukünftig viele Aufgaben übernehmen, die bislang menschlichem Intellekt vorbehalten waren.

Ein paar Beispiele gefälligst? Gerne.

Künstliche Intelligenz im Alltag

Da gibt es die ultraschnellen „Textversteher“ die aus allen Arten von Veröffentlichungen Wissen auffinden oder die unterschiedlichsten Assistenzsysteme für das Alltagsleben. Da gibt es Interpretationsmaschinen, die uns beim Autofahren unterstützen und später einmal autonomes Fahren ermöglichen sollen. Da gibt es Systeme für dynamische Entscheidungsfindung für Unternehmen, sowie Systeme für die Cybersicherheit und Betrugserkennung bzw. -Prävention. KI findet sich überall im Alltag wieder. Musikdienste lernen unseren Musikgeschmack und stellen uns geschmacksbasierte Playlists zur Verfügung. Handys entsperren sich per FaceID und via AI werden sichtbare „Störemotionen“ eliminiert.

Wollen wir die Beispiele als AI bezeichnen? Das spielt keine Rolle, denn wir erleben gerade den Beginn einer neuen Ära. Wir erleben wie menschliches Kognitionsvermögen auf Maschinen übertragen wird. Zugegeben, das sind nur kleine, aber wichtige Teilbereiche, sie sind aber prinzipiell beliebig zu vervielfachen und zu beschleunigen.

Evolution von Data Mining

Als ich mich vor 20 Jahren das erste Mal mit dem Thema beschäftigt habe, hieß das Kind noch „Data Mining“. Der Begriff Data Mining beinhaltet viele unterschiedliche Methoden, wie aus Daten Erkenntnisse abgeleitet werden können. Hierzu wird mittels Methoden, unter anderem statistische Algorithmen, maschinelles Lernen, Textanalysen, Zeitreihenanalysen und sonstige analytische Verfahren nach unbekannten Mustern gesucht oder um es mit anderen Worten zu sagen, da wird DIE Nadel im Nadelhaufen gesucht, die „anders“ ist. Aus dem guten alten Data Mining entwickelten sich aktuelle AI-Methoden, auf die wir kurz eingehen wollen.

Machine Learning

Das Ziel beim maschinellen Lernen liegt wie bei statistischen Modellen in der Strukturerkennung von Daten – also die theoretische Verteilung auf bekannte Daten zu übertragen. Während statische Modelle auf einer mathematisch bewiesenen Theorie basieren und die Daten gleichzeitig bestimmten Annahmen entsprechen müssen, werden beim Machine Learning Daten mithilfe von Computern auf unbekannte Strukturen untersucht. Es muss keine Theorie über die Art der Strukturen vorliegen. Beim Machine Learning spielen interaktive Techniken eine wichtige Rolle, was sich wiederum hervorragend automatisieren lässt. So werden in wiederholenden Durchläufen Daten solange untersucht, bis ein verlässliches Muster gefunden ist.

Deep Learning

Als Teildisziplin des Machine Learnings, setzt Deep Learning (DL) auf den Einsatz von künstlichen neuronalen Netzen. Beruht beispielsweise die Idee von Entscheidungsbäumen auf einer gewissen mathematischen Logik, beruhen künstlich neuronale Netze auf dem Vorbild der Natur, nämlich biologisch neuronalen Netzen.

DL nutzt die immer gewaltigere Rechenleistung – und diese steht heute in der Cloud nahezu unbegrenzt zur Verfügung – um in riesigen Datenmengen komplexe Muster zu erkennen. Gerade bei der Erkennung von Objekten in Bildern oder von Wörtern in Lautfolgen ist DL state-of-the-art. Aktuelle Forschungsprojekte arbeiten an hochkomplexer Mustererkennung um Aufgaben wie die Übersetzung von natürlicher Sprache oder medizinische Diagnostik zu automatisieren.

Cognitive Computing

Cognitive Computing bezieht sich auf den Prozess der Reflexion menschlicher Denkprozesse in einer computerisierten Umgebung. In diesem Prozess simulieren selbstlernende Algorithmen die Funktionsweise eines menschlichen Gehirns, indem sie Mustererkennung, Data Mining und Spracherkennung nutzen. Cognitive Computing wird von Tag zu Tag beliebter; es wird in großem Umfang in den Bereichen Künstliche Intelligenz, Robotik, neuronale Netze, virtuelle Realität und ähnlichen Anwendungen eingesetzt. Die Systeme sind darauf trainiert, die Bedeutung, das Datum, die Uhrzeit, die Syntax, die Domäne, den Standort der zu untersuchenden Daten zu identifizieren und zu extrahieren.

Das Hauptziel von Cognitive Computing ist die Schaffung selbständiger IT-Systeme mit unabhängigen Problemlösungsfähigkeiten, die kein menschliches Eingreifen erfordern. Die Systeme lernen und verfeinern sich kontinuierlich mit den Daten, die ihnen zugeführt werden. Dieser Prozess hilft ihnen, im Laufe der Zeit besser in der Lage zu sein, Aufgaben eigenständig zu lösen. Genau wie das menschliche Gehirn, das mit allen wichtigen Systemen des Körpers kommuniziert, beinhaltet auch Cognitive Computing die Interaktion mit allen Teilen eines Systems. Gleichzeitig muss das System in der Lage sein, sich alles, was es in den vorangegangenen Prozessen gelernt hat, zu „merken“ und je nach Aufgabenstellung entsprechend darzustellen.

Allgemein und nicht technisch

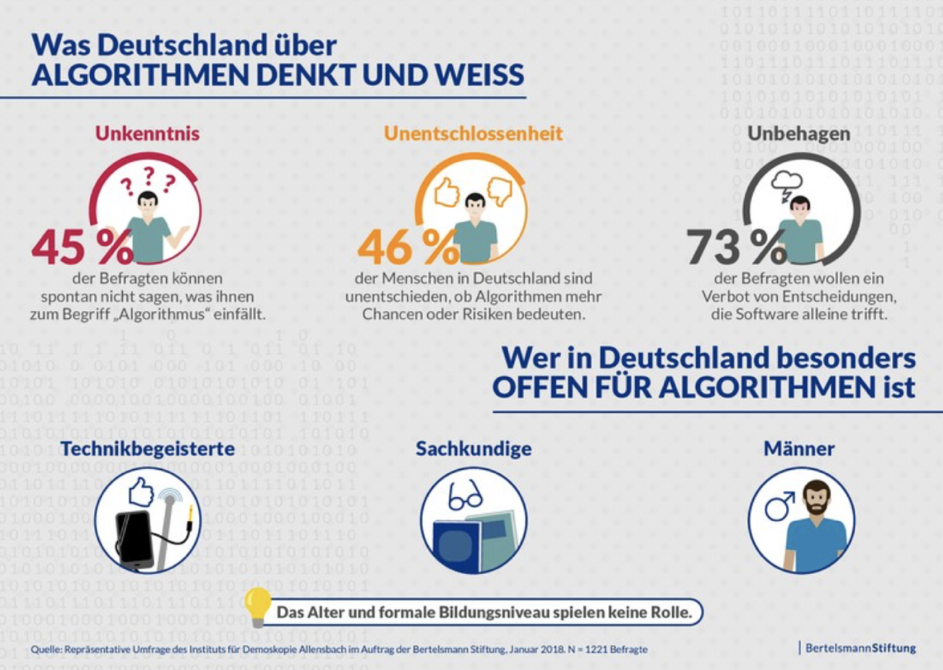

Neben all den technischen Informationen im oberen Teil stellt sich nun die Frage, ob wir für AI bereit sind? Hierzu möchten wir kurz eine Studie der Bertelsmann Stiftung und deren Ergebnisse heranziehen.

Man sieht, dass die obigen Ergebnisse nicht gerade eine breite Akzeptanz zeigen und es kommt noch dicker, denn nach einer Bitkom-Studie möchte jeder Zweite das Thema besser verstehen. Hier sind neue Konzepte und Wege gefragt. Hier müssen Politik, Wirtschaft und Bildung dringend reagieren, denn nur wenn es gelingt Klischees und vorhandenen Ängste und Vorbehalte abzubauen, wird AI sich weiter durchsetzen

In seinem Buch „The Master Algorithm“ schreibt Pedro Domingos:

„Die Menschen haben Angst, dass Computer zu schlau werden und unsere Welt übernehmen könnten. Das eigentliche Problem ist aber doch, dass sie dumm sind und die Welt bereits übernommen haben.“

Interessant, wenn man mal die Perspektive wechselt, denn es ist unbedeutend, ob in der Zukunft nicht auch ein schlauer Mensch diese Übernahme vollziehen kann. Es ist die Frage, wie viel Raum wir Maschinen geben wollen. Hierzu ein paar Fakten aus einer weiteren Studie:

- 9 Prozent würden die Frage nach einer Gehaltserhöhung lieber von einer KI als von ihrem Chef entscheiden lassen

- 15 Prozent würden sich bei einem Kredit lieber von einer KI als von einem Bankangestellten beraten lassen

- 9 Prozent halten die Entscheidung einer KI in einem Beziehungsstreit für sinnvoll

All das sind Räume, bei denen wir entscheiden müssen, ob wir sie künstlichen Intelligenzen überlassen. Denn diesen Beispielen ist eines gemein: Sie entmündigen mich, da ich wesentliche Spielarten der menschlichen Kommunikation nicht mehr brauche.

Ein gutes Beispiel für die Bequemlichkeit des Homo Sapiens. Bei meiner Gehaltverhandlung brauche ich Verhandlungsgeschick, wenn ich einen Kredit benötige, sind Grundkenntnisse von Finanzen und Zinsen sinnvoll und in einer Beziehung sind kommunikative Fähigkeiten gefragt. Bevor es jetzt zu philosophisch wird, endet dieser Beitrag hier. Wir werden uns aber mit den Einflüssen von KI auf mittelständische Unternehmen beschäftigen. Da kennen wir uns nämlich bestens aus. Mehr dazu also in Kürze im nächsten Blogbeitrag.